Anatomía de la desinformación electoral

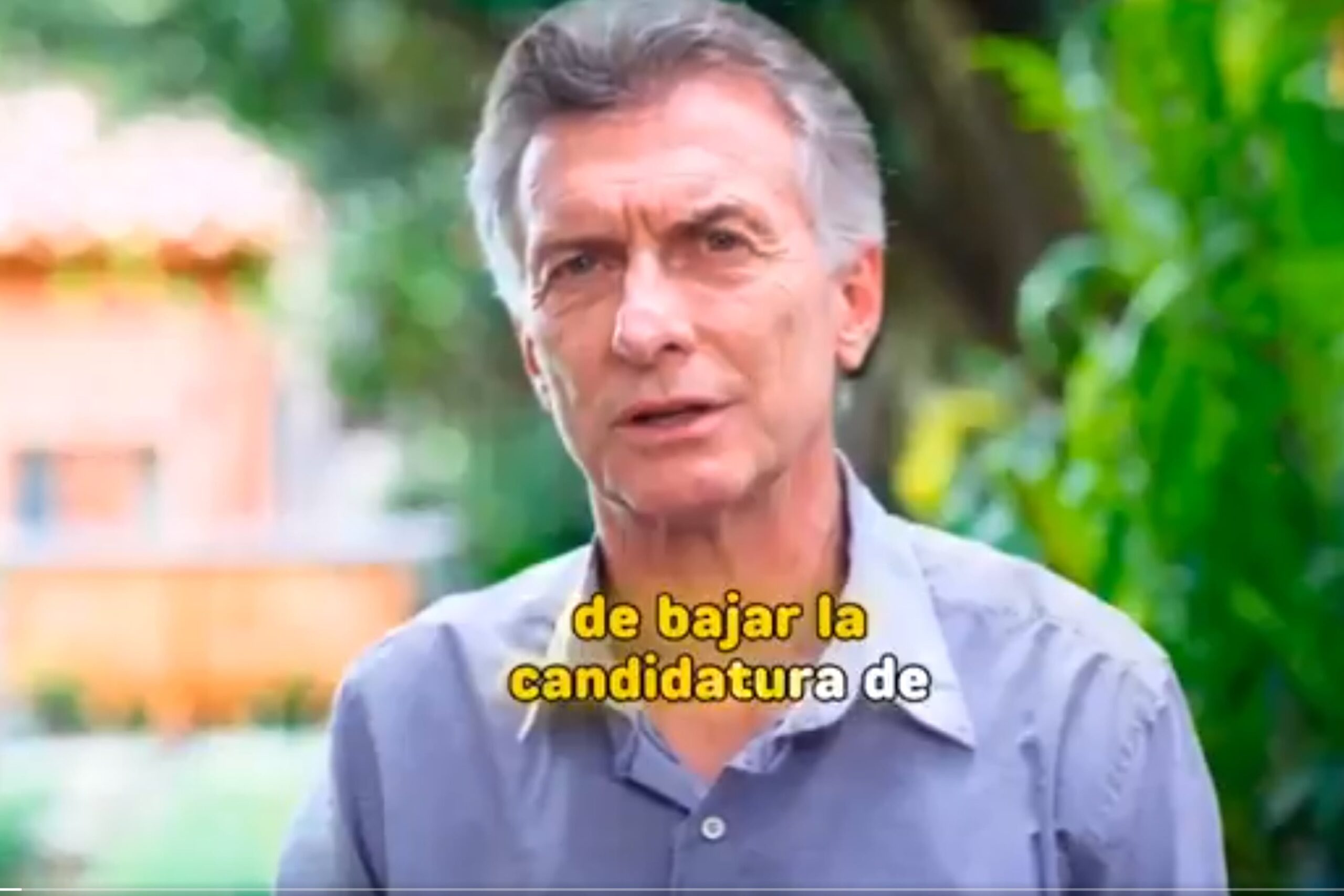

La desinformación electoral ya no depende de rumores o trolls, sino de realidades fabricadas que erosionan la confianza pública. En plena campaña electoral, mientras proliferan tecnologías capaces de producir audios, fotos y videos falsos, la Justicia federal reaccionó ante el riesgo. El fiscal Ramiro González pidió habilitar una acción de amparo para frenar “acciones masivas de desinformación” basadas en inteligencia artificial. Su advertencia acompañó la denuncia del constitucionalista Andrés Gil Domínguez, quien alertó sobre el uso creciente de deepfakes en campañas electorales, como las que involucraron a Mauricio Macri y Silvia Lospennato en mayo de 2025. También reclamó informes al Gobierno sobre medidas para promover el voto informado e insistió en el Compromiso Ético Digital impulsado por la Cámara Nacional Electoral.

Aunque redes como X poseen reglas que prohíben suplantaciones de identidad, automatizaciones y contenido manipulado, ese marco normativo resulta insuficiente frente a operaciones organizadas. Estas reglas sostienen que las cuentas deben ser genuinas: no se admiten automatizaciones, identidades falsas ni suplantaciones, salvo cuando se trate de cuentas de parodia (PCF). En teoría, X sanciona publicaciones con material alterado o engañoso, limita visibilidad o suspende cuentas reincidentes. En la práctica, el sistema se aplica con criterios opacos.

El caso ocurrido en la elección porteña de 2025 expuso el problema en toda su crudeza. El 17 de mayo, en plena veda electoral, circuló un video donde un supuesto Mauricio Macri, trucado con inteligencia artificial, anunciaba la baja de la candidatura de Silvia Lospennato y su apoyo a Manuel Adorni. Era falso, pero se viralizó entre las 19 y las 23 con una coordinación difícil de atribuir al azar. El monitoreo realizado por Civic Compass detectó que el video fue difundido inicialmente por la cuenta parodia @TTendenciaX, dio inicio a una cascada coordinada de posteos, retuits y comentarios por parte de cuentas de influencers libertarios, previamente identificadas por LA NACION como parte del “anillo digital de Milei”.

La cuenta @TTendenciaX opera en esa zona gris donde el humor, la ideología y la manipulación se confunden. Su biografía “Tendencias (o no) en Argentina. Parodia.” sugiere ironía, pero sus publicaciones funcionan como vehículos de desinformación política revestidos de sátira.

El 17 de mayo, su posteo con el video falso se propagó con una rapidez que desbordó la capacidad de reacción tanto de las plataformas como de las autoridades. En apenas dos horas, el contenido fue respondido, compartido o citado en cientos de miles de posteos, sin que existiera ningún aviso sobre su falsedad. Recién cerca de las 22 horas, la red social X aplicó la etiqueta “contenido multimedia alterado”, mientras los usuarios seguían comentando y amplificando el material.

Las “cuentas parodia” se han convertido en zonas de excepción dentro del ecosistema digital, utilizadas tanto para propaganda como para campañas de desinformación. Amparadas en la idea de “humor político”, logran eludir los mecanismos de control, y cuando son señaladas, responden que su contenido “no debe tomarse literalmente”. Esa ambigüedad es precisamente lo que las vuelve tan efectivas.

El análisis horario de los datos muestra que la difusión del video siguió un patrón muy claro. La curva de actividad crece abruptamente a partir de las 19 (hora local), alcanza su pico entre las 20.30 y las 22, y comienza a descender hacia la medianoche. Durante ese lapso, las cuentas más activas fueron @TommySheIby_30, con 79 publicaciones, y @TraductorTeAma, con 48. En este caso, la difusión del video operó como una operación relámpago de desinformación electoral, diseñada para aprovechar el vacío de comunicación durante la veda y sembrar confusión sobre alianzas políticas.

Mientras tanto, ninguna autoridad electoral intervino. La Justicia porteña, que debía actuar por tratarse de una elección local, no emitió advertencias. El Estado llega tarde porque no tiene herramientas: Argentina, en todos sus niveles, carece de protocolos para actuar frente a desinformación en contextos electorales, no posee equipos de monitoreo, ni canales de respuesta rápida con plataformas tecnológicas, ni una regulación clara que permita sancionar estas maniobras sin afectar la libertad de expresión.

Desde Civic Compass pudimos reconstruir que esa noche, la primera intervención de verificación no vino del Estado, sino del sistema de notas comunitarias de X y de los medios tradicionales. A las 21.54, Diario Perfil agregó una nota comunitaria debajo del video original, aclarando que el contenido era falso y que había sido manipulado mediante inteligencia artificial. Esa nota comunitaria se extendió a 108 publicaciones con el video. Casi tres horas después, a las 0.42 del 18 de mayo, LA NACION hizo lo propio, aportando contexto adicional y citando fuentes de verificación independientes.

Las notas comunitarias son una herramienta colaborativa que permite a usuarios verificados o medios acreditados agregar contexto a publicaciones engañosas. En la práctica, funcionan como un sistema de defensa: no eliminan el contenido, pero advierten a quienes lo ven sobre su falsedad o manipulación. El problema, muchas veces, es su ineficacia temporal. Llegan cuando la ola ya se desbordó. El daño simbólico -la duda instalada, el impacto emocional y la circulación del contenido- ocurre en los primeros minutos, no en las horas posteriores. Por eso se las puede calificar como “modelos subóptimos pero necesarios”: paliativos que, aunque limitados, son hoy el único mecanismo visible de corrección. Así, la defensa de la integridad informativa queda librada a la buena voluntad de las plataformas y a la reacción espontánea de los medios o los usuarios.

El episodio expone algo más profundo que un caso aislado. Muestra un sistema mediático y tecnológico que premia la velocidad sobre la veracidad. Como ha sido ampliamente dicho, las plataformas basadas en algoritmos de recomendación, como X, TikTok o Instagram, no penalizan la desinformación, la amplifican, siempre que genere clics y comentarios.

Muchos expertos en alfabetización mediática recomiendan estrategias de prebunking sofisticadas: anticipar las narrativas falsas antes de que se instalen; cubrir vacíos informativos; o generar materiales informativos que sean claros, accesibles y fáciles de compartir. Pero para eso se necesitan equipos permanentes, coordinación institucional y colaboración entre medios, sociedad civil y plataformas. En la Argentina, ninguna de esas condiciones existe hoy.

El caso Macri-Lospennato demuestra que la desinformación electoral ya no necesita ser sofisticada para ser efectiva. Basta una imagen generada por IA, un título provocador y un grupo de cuentas alineadas para multiplicar un engaño en minutos. Y mientras las plataformas se resguardan en sus políticas internas, y el Estado mira para otro lado, el costo lo paga el debate público. La desinformación no solo distorsiona hechos: reconfigura la confianza. Cada imagen o video falso que circula sin control, erosiona un poco más la frontera entre lo cierto y lo posible. En esa grieta digital, sin árbitros, sin protocolos y sin rendición de cuentas, se juega una parte de la democracia argentina contemporánea.

Investigadora en Civic Compass y Profesora de Ciencia Política (UBA)

La desinformación electoral ya no depende de rumores o trolls, sino de realidades fabricadas que erosionan la confianza pública. En plena campaña electoral, mientras proliferan tecnologías capaces de producir audios, fotos y videos falsos, la Justicia federal reaccionó ante el riesgo. El fiscal Ramiro González pidió habilitar una acción de amparo para frenar “acciones masivas de desinformación” basadas en inteligencia artificial. Su advertencia acompañó la denuncia del constitucionalista Andrés Gil Domínguez, quien alertó sobre el uso creciente de deepfakes en campañas electorales, como las que involucraron a Mauricio Macri y Silvia Lospennato en mayo de 2025. También reclamó informes al Gobierno sobre medidas para promover el voto informado e insistió en el Compromiso Ético Digital impulsado por la Cámara Nacional Electoral.Aunque redes como X poseen reglas que prohíben suplantaciones de identidad, automatizaciones y contenido manipulado, ese marco normativo resulta insuficiente frente a operaciones organizadas. Estas reglas sostienen que las cuentas deben ser genuinas: no se admiten automatizaciones, identidades falsas ni suplantaciones, salvo cuando se trate de cuentas de parodia (PCF). En teoría, X sanciona publicaciones con material alterado o engañoso, limita visibilidad o suspende cuentas reincidentes. En la práctica, el sistema se aplica con criterios opacos.El caso ocurrido en la elección porteña de 2025 expuso el problema en toda su crudeza. El 17 de mayo, en plena veda electoral, circuló un video donde un supuesto Mauricio Macri, trucado con inteligencia artificial, anunciaba la baja de la candidatura de Silvia Lospennato y su apoyo a Manuel Adorni. Era falso, pero se viralizó entre las 19 y las 23 con una coordinación difícil de atribuir al azar. El monitoreo realizado por Civic Compass detectó que el video fue difundido inicialmente por la cuenta parodia @TTendenciaX, dio inicio a una cascada coordinada de posteos, retuits y comentarios por parte de cuentas de influencers libertarios, previamente identificadas por LA NACION como parte del “anillo digital de Milei”.La cuenta @TTendenciaX opera en esa zona gris donde el humor, la ideología y la manipulación se confunden. Su biografía “Tendencias (o no) en Argentina. Parodia.” sugiere ironía, pero sus publicaciones funcionan como vehículos de desinformación política revestidos de sátira.El 17 de mayo, su posteo con el video falso se propagó con una rapidez que desbordó la capacidad de reacción tanto de las plataformas como de las autoridades. En apenas dos horas, el contenido fue respondido, compartido o citado en cientos de miles de posteos, sin que existiera ningún aviso sobre su falsedad. Recién cerca de las 22 horas, la red social X aplicó la etiqueta “contenido multimedia alterado”, mientras los usuarios seguían comentando y amplificando el material.Las “cuentas parodia” se han convertido en zonas de excepción dentro del ecosistema digital, utilizadas tanto para propaganda como para campañas de desinformación. Amparadas en la idea de “humor político”, logran eludir los mecanismos de control, y cuando son señaladas, responden que su contenido “no debe tomarse literalmente”. Esa ambigüedad es precisamente lo que las vuelve tan efectivas.El análisis horario de los datos muestra que la difusión del video siguió un patrón muy claro. La curva de actividad crece abruptamente a partir de las 19 (hora local), alcanza su pico entre las 20.30 y las 22, y comienza a descender hacia la medianoche. Durante ese lapso, las cuentas más activas fueron @TommySheIby_30, con 79 publicaciones, y @TraductorTeAma, con 48. En este caso, la difusión del video operó como una operación relámpago de desinformación electoral, diseñada para aprovechar el vacío de comunicación durante la veda y sembrar confusión sobre alianzas políticas.Mientras tanto, ninguna autoridad electoral intervino. La Justicia porteña, que debía actuar por tratarse de una elección local, no emitió advertencias. El Estado llega tarde porque no tiene herramientas: Argentina, en todos sus niveles, carece de protocolos para actuar frente a desinformación en contextos electorales, no posee equipos de monitoreo, ni canales de respuesta rápida con plataformas tecnológicas, ni una regulación clara que permita sancionar estas maniobras sin afectar la libertad de expresión.Desde Civic Compass pudimos reconstruir que esa noche, la primera intervención de verificación no vino del Estado, sino del sistema de notas comunitarias de X y de los medios tradicionales. A las 21.54, Diario Perfil agregó una nota comunitaria debajo del video original, aclarando que el contenido era falso y que había sido manipulado mediante inteligencia artificial. Esa nota comunitaria se extendió a 108 publicaciones con el video. Casi tres horas después, a las 0.42 del 18 de mayo, LA NACION hizo lo propio, aportando contexto adicional y citando fuentes de verificación independientes.Las notas comunitarias son una herramienta colaborativa que permite a usuarios verificados o medios acreditados agregar contexto a publicaciones engañosas. En la práctica, funcionan como un sistema de defensa: no eliminan el contenido, pero advierten a quienes lo ven sobre su falsedad o manipulación. El problema, muchas veces, es su ineficacia temporal. Llegan cuando la ola ya se desbordó. El daño simbólico -la duda instalada, el impacto emocional y la circulación del contenido- ocurre en los primeros minutos, no en las horas posteriores. Por eso se las puede calificar como “modelos subóptimos pero necesarios”: paliativos que, aunque limitados, son hoy el único mecanismo visible de corrección. Así, la defensa de la integridad informativa queda librada a la buena voluntad de las plataformas y a la reacción espontánea de los medios o los usuarios.El episodio expone algo más profundo que un caso aislado. Muestra un sistema mediático y tecnológico que premia la velocidad sobre la veracidad. Como ha sido ampliamente dicho, las plataformas basadas en algoritmos de recomendación, como X, TikTok o Instagram, no penalizan la desinformación, la amplifican, siempre que genere clics y comentarios.Muchos expertos en alfabetización mediática recomiendan estrategias de prebunking sofisticadas: anticipar las narrativas falsas antes de que se instalen; cubrir vacíos informativos; o generar materiales informativos que sean claros, accesibles y fáciles de compartir. Pero para eso se necesitan equipos permanentes, coordinación institucional y colaboración entre medios, sociedad civil y plataformas. En la Argentina, ninguna de esas condiciones existe hoy.El caso Macri-Lospennato demuestra que la desinformación electoral ya no necesita ser sofisticada para ser efectiva. Basta una imagen generada por IA, un título provocador y un grupo de cuentas alineadas para multiplicar un engaño en minutos. Y mientras las plataformas se resguardan en sus políticas internas, y el Estado mira para otro lado, el costo lo paga el debate público. La desinformación no solo distorsiona hechos: reconfigura la confianza. Cada imagen o video falso que circula sin control, erosiona un poco más la frontera entre lo cierto y lo posible. En esa grieta digital, sin árbitros, sin protocolos y sin rendición de cuentas, se juega una parte de la democracia argentina contemporánea.Investigadora en Civic Compass y Profesora de Ciencia Política (UBA) Opinión

Leave a Comment